静态图片转换为动态视频是一种有趣且实用的技术,可以用于动画制作、演示、游戏开发等多个领域。以下是一个使用开源工具将静态图片转换为动态视频的详细步骤:

### 1. 选择合适的工具

目前有很多开源工具可以将静态图片转换为动态视频,以下是一些受欢迎的选择:

- "FFmpeg":一个强大的多媒体处理工具,支持多种视频格式。

- "ImageMagick":一个图像处理和转换工具,可以批量处理图片。

- "OpenCV":一个开源计算机视觉库,可以进行图像和视频处理。

### 2. 安装所需工具

以下是在Linux系统中安装FFmpeg的步骤:

```bash

sudo apt-get update

sudo apt-get install ffmpeg

```

### 3. 准备静态图片

确保你有你想要转换的静态图片文件。通常,这些图片是JPEG或PNG格式。

### 4. 使用FFmpeg进行转换

以下是一个简单的FFmpeg命令,将一系列静态图片转换为动态视频:

```bash

ffmpeg -f image2 -i image_%03d.png -vf fps=10 -vcodec libx264 output.mp4

```

这里的参数解释如下:

- `-f image2`:指定输入文件类型为图像。

- `-i image_%03d.png`:指定输入文件,`%03d`是一个占位符,表示图片的序号,`image_000.png`,`image_001.png

相关内容:

前言

大家好,欢迎来到AI解码师的频道。今天我们来介绍一款最近非常火的免费开源项目。它只需要一张图片就可以生成可控制的动态视频,让AI生成的视频中的人物实现表情动作的移花接木。比如像下面这个美女视频,他所做的动作表情都是完全模仿左边这个搞怪视频的,而且生成这种视频,它原先就是一张静态图片而已。

视频加载中...

通过这款开源软件,可以让肖像眨眼、微笑或者转头等动作,不管是写实油画、雕塑、3D渲染或者是大尺度的那种,都能按我们要求将表情、动态等复制到其他人身上。当然,这种移花接木的神奇功能不仅仅限于单个人,搞个全家福也都是可以的。

当然,除了从静态图片做视频,还可以让一个或者多个视频实现笑容增加速。而且这种魔法不仅仅吸引人物肖像,像小猫小狗也都可以让他们实现,撒娇卖萌都是可以完全实现的。这个工具对人物表情控制更加精准,比如我们可以制定嘴角上扬的弧度,双眼放大的比例等等,都可以自定义。所以说基于这款开源软件,之前很多不敢想不敢做的事情竟然都可以轻松实现了,不得不感叹AI技术的发展的速度。

软件安装

这工具就是:LivePortrait,接下来作者将带大家一步一步安装并使用这一款开源神器,当然如果你嫌麻烦不想自己安装,作者也准备了免费的使用入口,需要的朋友可以在评论区告诉我,安装过程中有任何问题,也可以随时讨论。

和当前主流的基于扩散模型的方法不同,LivePortrait不依赖于图片中明确可见的标记或特征点,而是通过学习数据集中的模型来隐式推断关键点的位置。在此基础上,采用两个阶段从头开始训练模型,并在基于隐式关键点的框架上进行了多项改进。这些改进包括高质量的数据整理、混合图像和视频训练、网络架构的可扩展性、运动变焦以及地标引导的面部关键点优化等。这些模型的泛化能力使得它在表达能力和纹理质量上都有显著提升,同时在处理面部表情的细节时也更加精准。

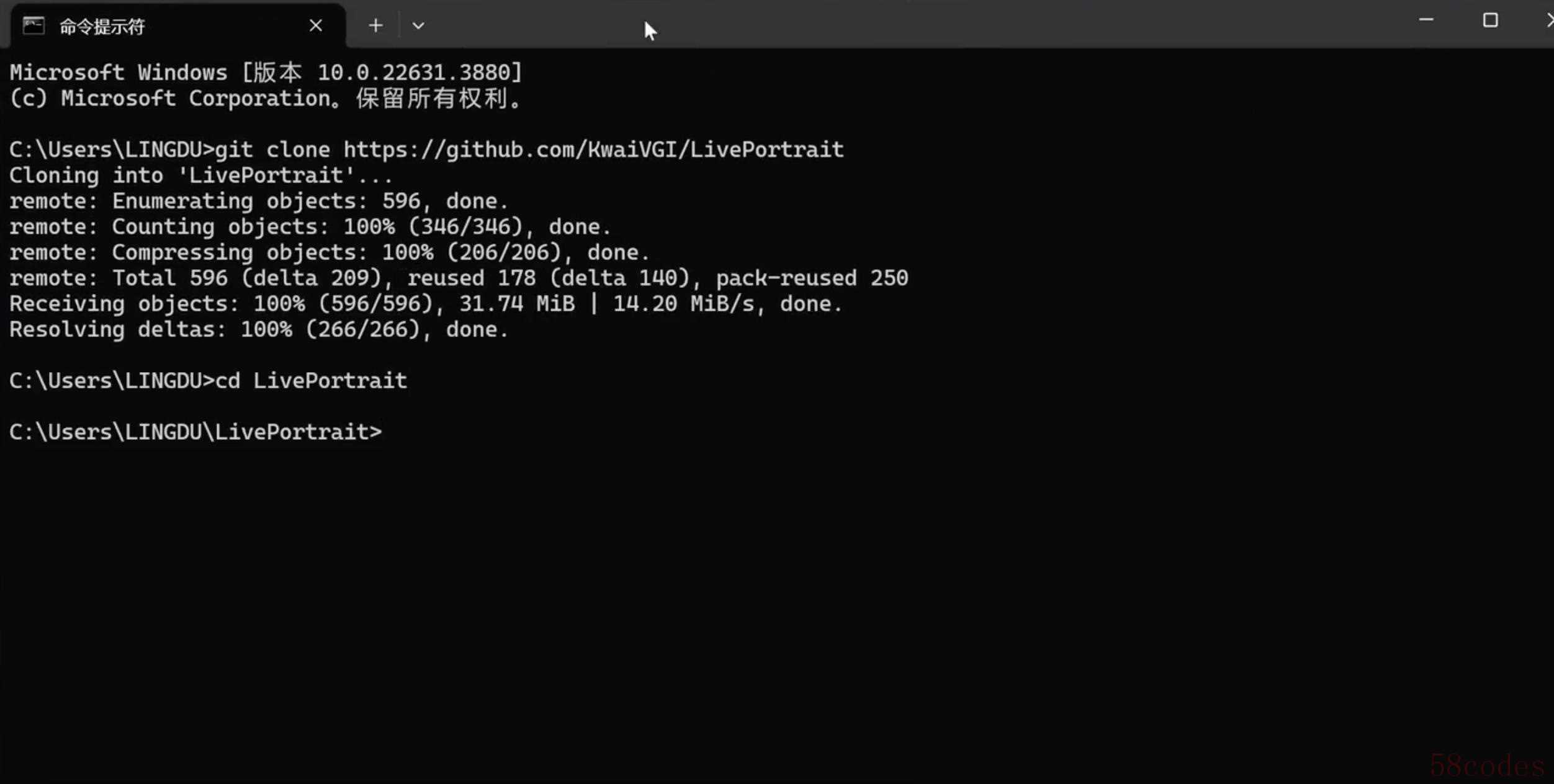

第一步:下载代码并安装必备环境

首先需要在我们本地电脑上下载LivePortrait的代码,复制下边这行指令,会自动下载这款开源项目,下载好以后,确认一下可以进入项目的根目录,如果结果如下图所示,就是安装成功。

git clone https://github.com/KwaiVGI/LivePortrait

cd LivePortrait

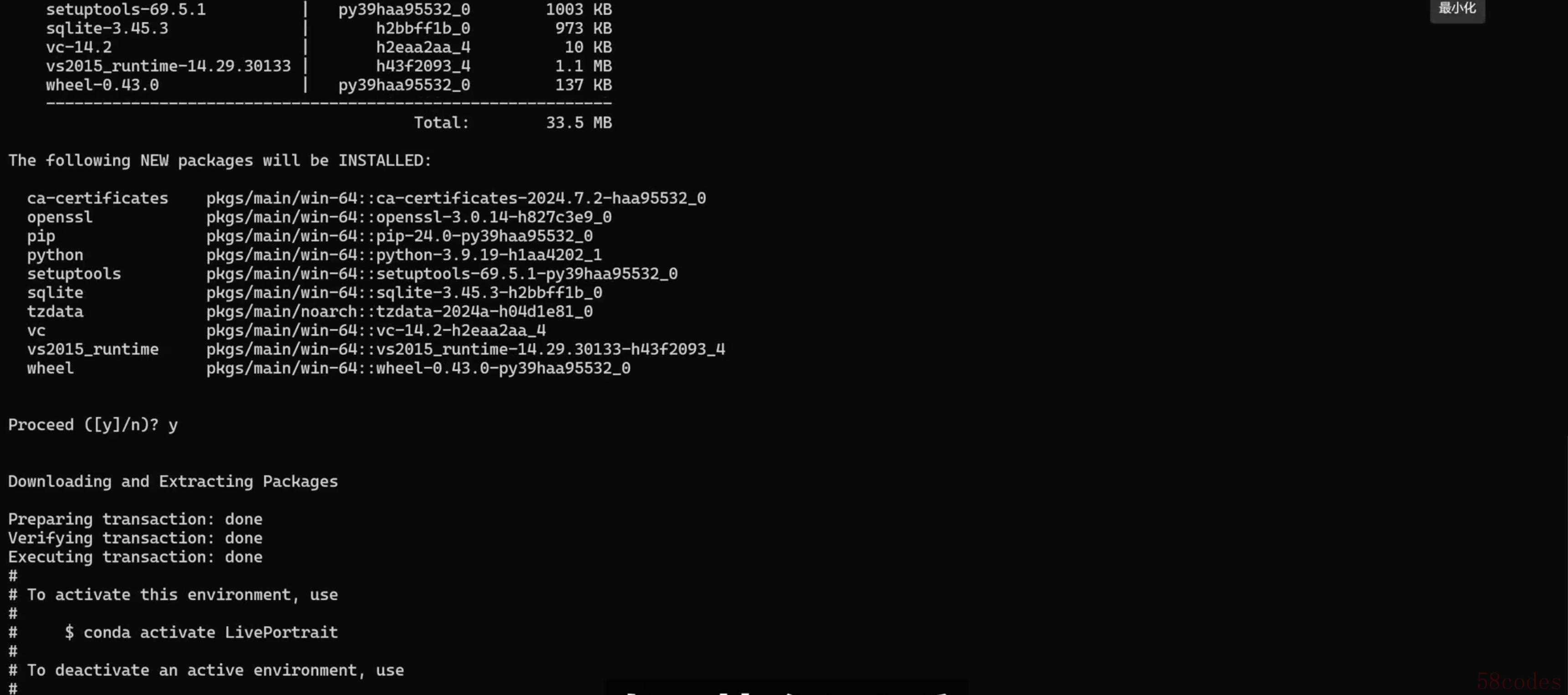

接着,复制下方这行代码出来,然后在命令提示符里粘贴,开始安装必备的软件包和运行环境。

conda create -n LivePortrait python=3.9

接下来继续运行下边这条命令,激活一个名为“LivePortrait”的 Conda 虚拟环境,主要是为了隔离和管理不同项目之间的依赖。

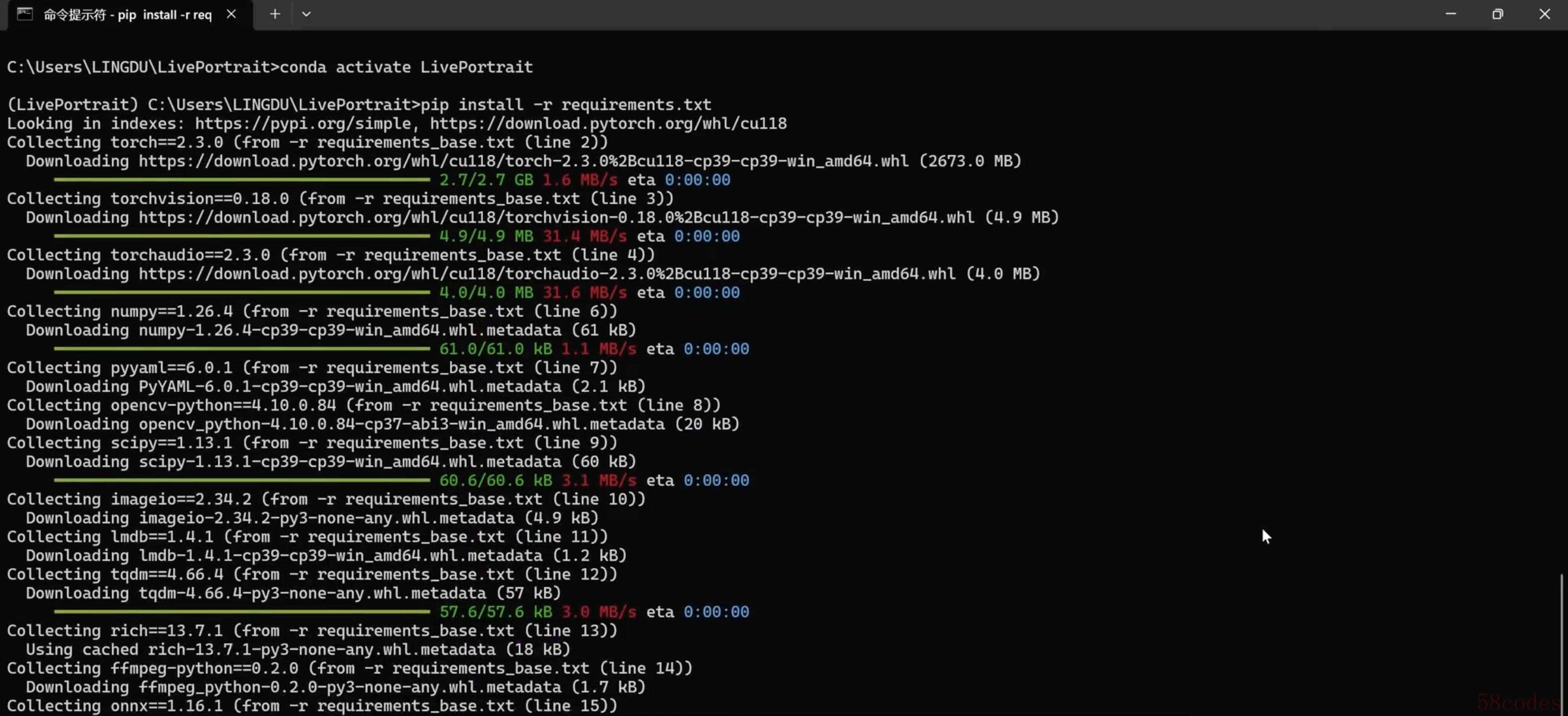

conda activate LivePortrait然后接下来需要注意了,如果遇到的是linux或者windows系统,就运行这条命令:

pip install -r requirements.txt如果是Mac电脑就运行这条命令:

pip install -r requirements_macOS.txt如果运行后出现如下界面,则表示运行成功,然后等待安装成功即可,这一步主要是给我们上面创建的虚拟环境安装程序所依赖的python包。

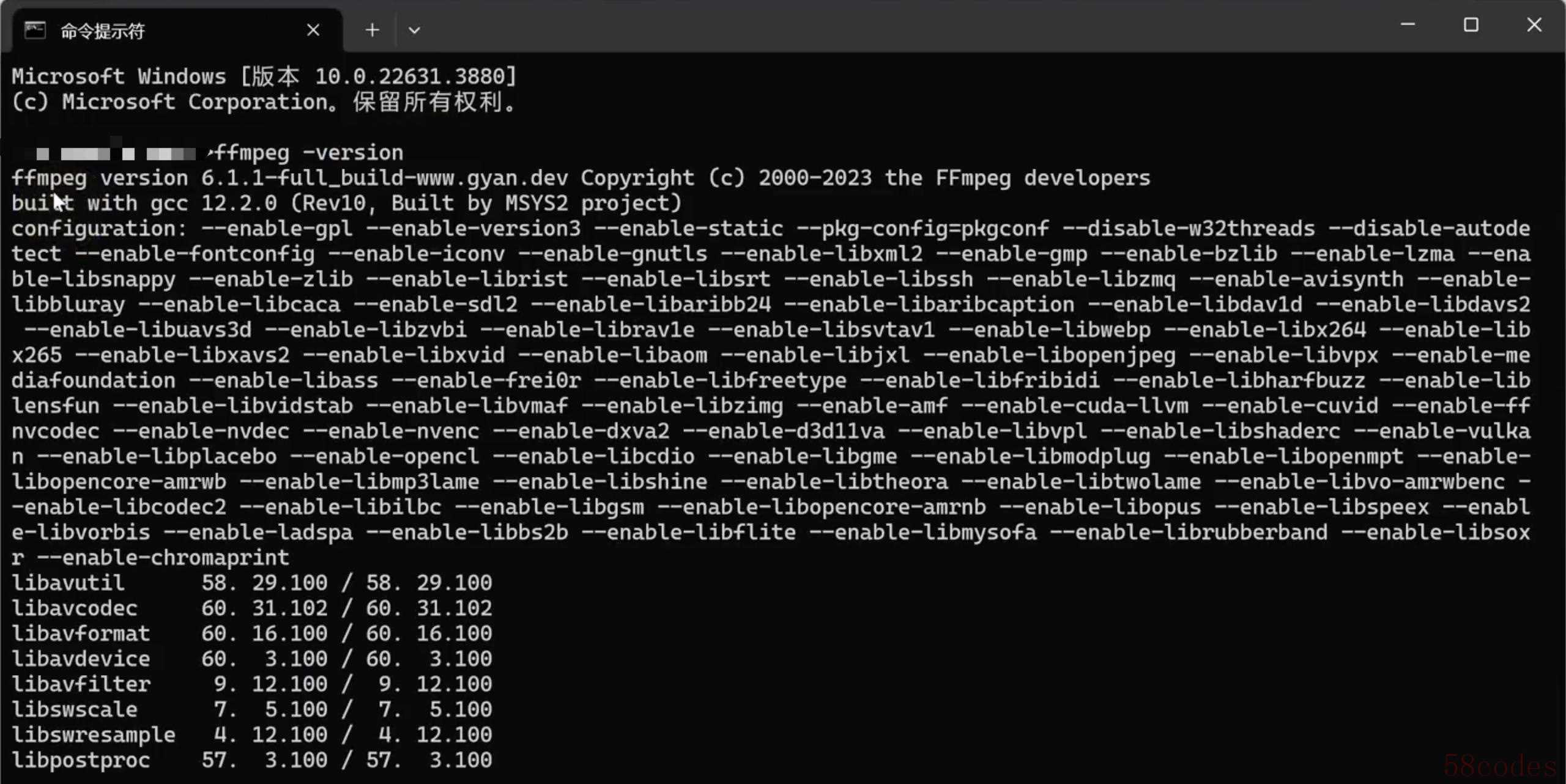

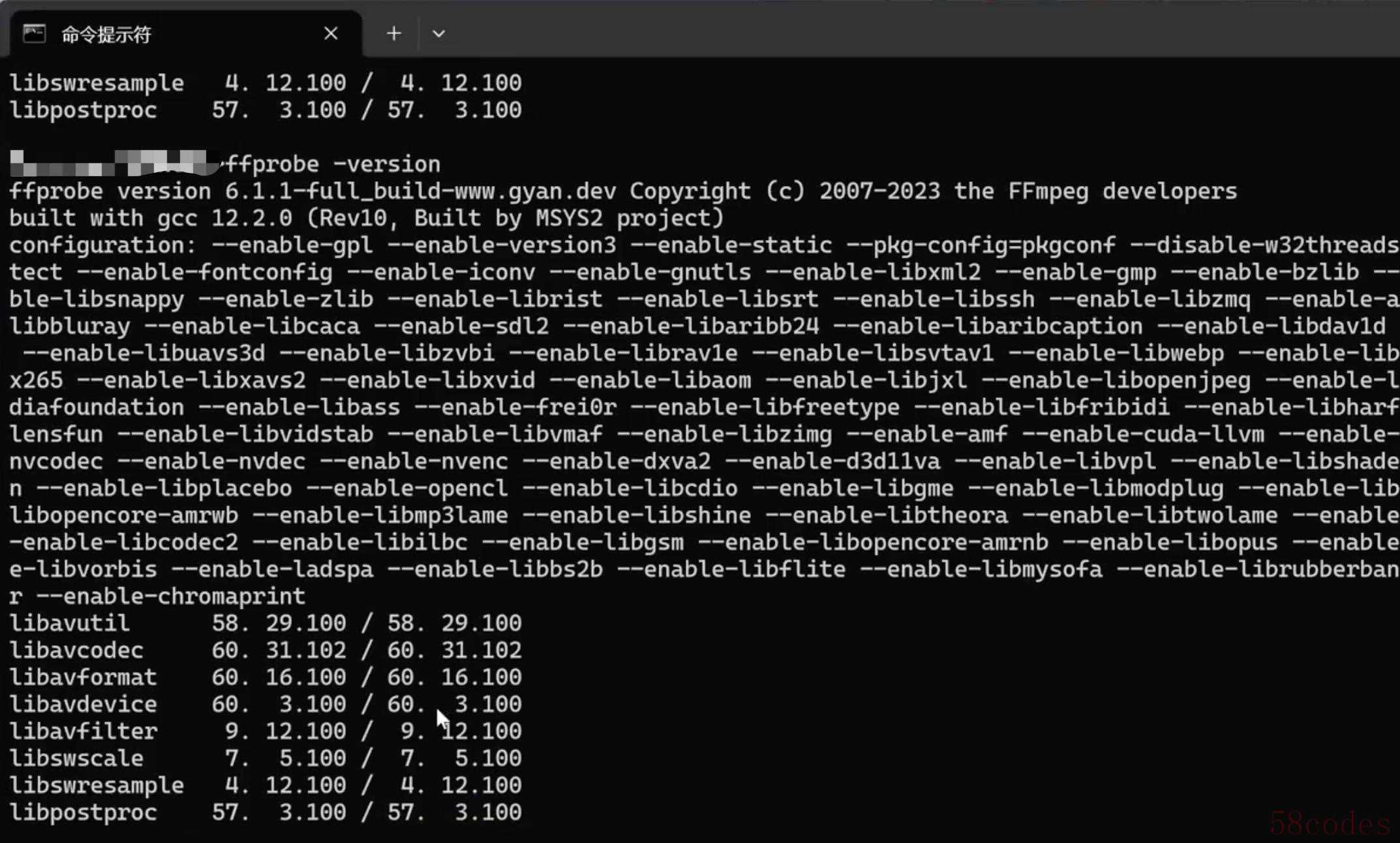

另外需要注意的事,运行这款开源软件,需要在电脑上安装ffmpeg。如果不清楚自己的电脑上是否安装这个环境,可以在终端输入下边这个命令,先确认一下,如果显示跟下方的截图一样,说明是安装成功的。

ffmpeg -version

接下来检查ffprobe是否已经安装:

ffprobe -version

第二步:下载预训练权重

最简单的下载方式就通过Hugging Face去下载,直接复制下边这段命令就可以了。

# first, ensure git-lfs is installed, see: https://docs.github.com/en/repositories/working-with-files/managing-large-files/installing-git-large-file-storage

git lfs install

# clone and move the weights

git clone https://huggingface.co/KwaiVGI/LivePortrait temp_pretrained_weights

mv temp_pretrained_weights/* pretrained_weights/

rm -rf temp_pretrained_weights如果没办法科学上网的朋友,也可以通过网盘下载,下载好以后,放到这个目录下./pretrained_weights,最后确保最终解压的目录如下所示即可。

pretrained_weights

├── insightface

│ └── models

│ └── buffalo_l

│ ├── 2d106det.onnx

│ └── det_10g.onnx

└── liveportrait

├── base_models

│ ├── appearance_feature_extractor.pth

│ ├── motion_extractor.pth

│ ├── spade_generator.pth

│ └── warping_module.pth

├── landmark.onnx

└── retargeting_models

└── stitching_retargeting_module.pth如何使用

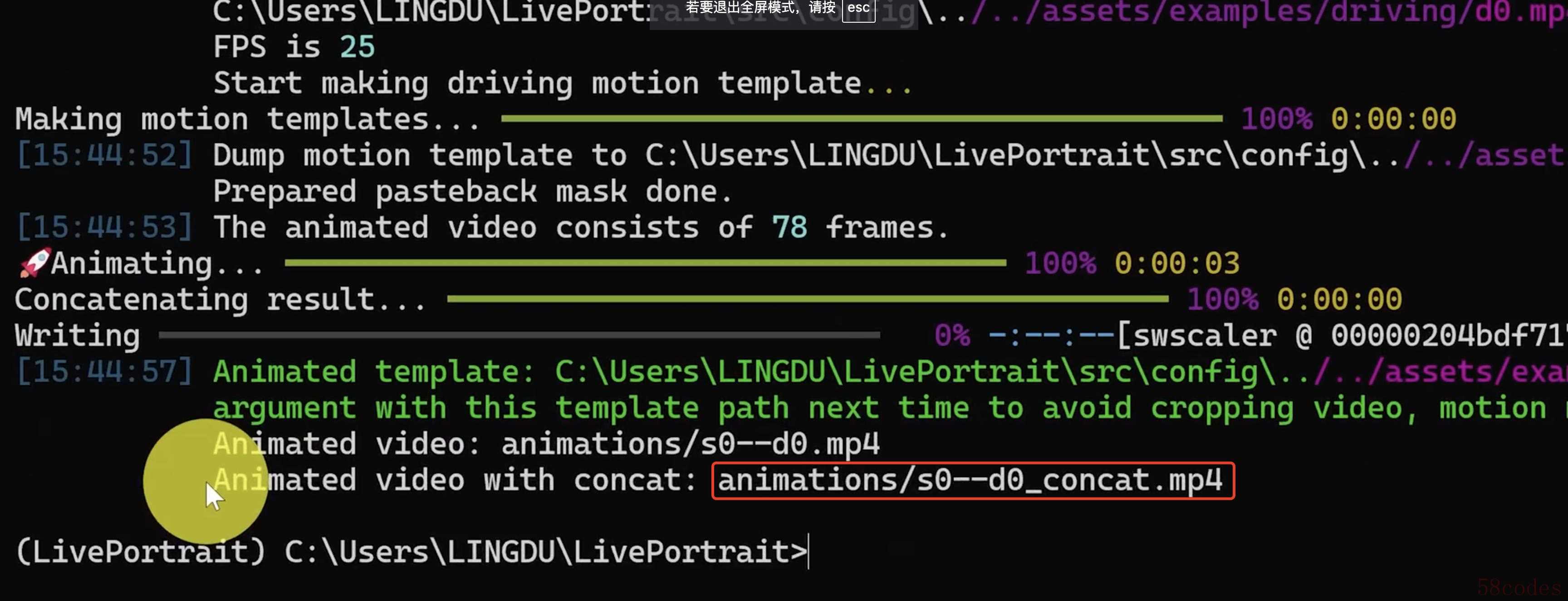

运行下方的命令,还是注意区分windows和Mac,作者已经标明:

# For Linux and Windows

python inference.py

# For macOS with Apple Silicon, Intel not supported, this maybe 20x slower than RTX 4090

PYTORCH_ENABLE_MPS_FALLBACK=1 python inference.py安装好以后,我们可以看到,他会把生成好的视频放到截图中作者红色方框圈选的位置。

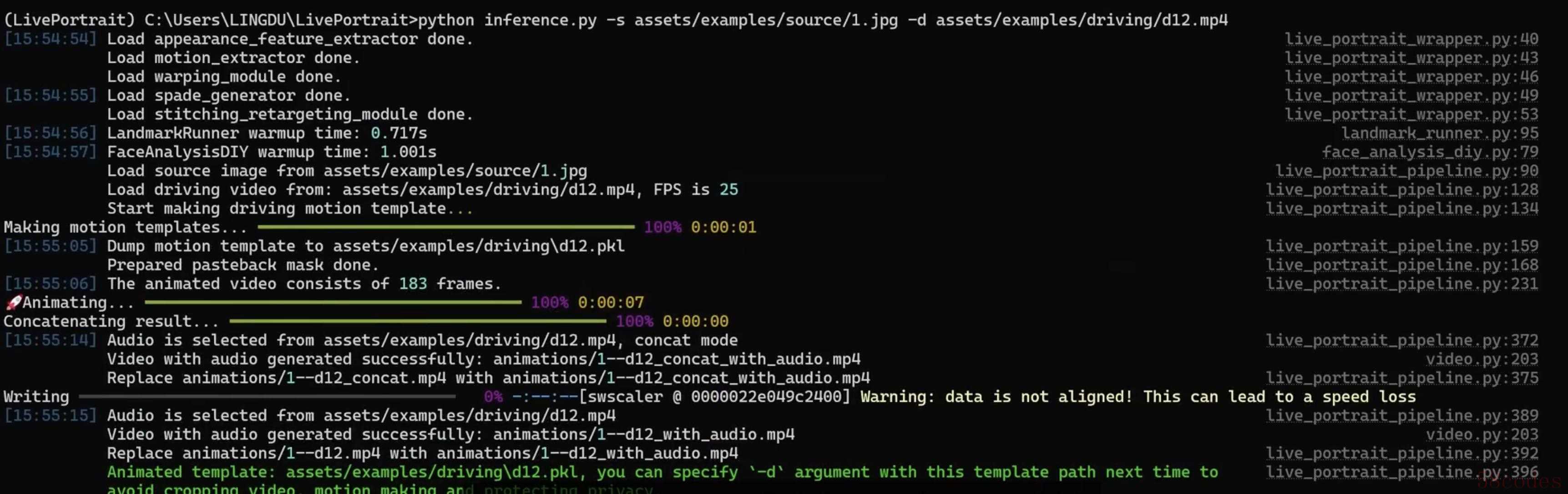

如果需要指定目标图片,还有目标视频,那么可以通过下方这个命令就可以了,注意要把图片和视频放到命令行指定的文件路径下。

# source input is an image(图片转视频)

python inference.py -s assets/examples/source/s9.jpg -d assets/examples/driving/d0.mp4

# source input is a video (视频转视频)

python inference.py -s assets/examples/source/s13.mp4 -d assets/examples/driving/d0.mp4

# more options to see

python inference.py -h我们还是找文章开头的那个案例试验一下:

视频加载中...

总结

以上就是通过静态图片转动态视频的全部内容,希望这篇文章对大家有所帮助,如果有任何问题可以在评论区留言讨论。

微信扫一扫打赏

微信扫一扫打赏

支付宝扫一扫打赏

支付宝扫一扫打赏